Forbes sitesinde yer alan bir haberin başlığı şu şekilde: “ChatGPT Hızla ChatMD mi Oluyor?”

Haberde, ChatGPT’nin ABD’de gerçekleştirilen Tıbbi Lisanslama Sınavı’nın (bizdeki TUS) üç bölümünde de ‘geçme eşiğinde veya buna yakın’ performans gösterdiği ifade ediliyor. O yüzden de, yapay zekânın tıp eğitimine ve potansiyel olarak klinik karar verme süreçlerine yardımcı olma potansiyeline sahip olabileceği ifade edildiği belirtiliyor.

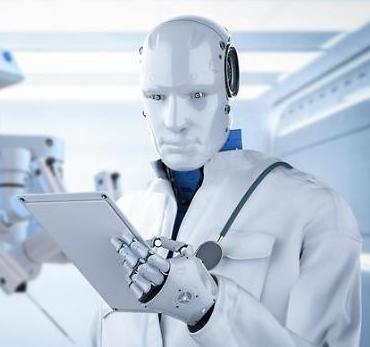

Esasen, tıp alanında yapay zekânın kanser olmak üzere pek çok hastalığın erken teşhis ve tedavisinde destek amaçlı kullanımının başarılı sonuçlar verdiğini gösteren çok sayıda araştırma söz konusu. Ancak bu noktada asıl merak edilen konu, diğer sektörlerde uzun süredir gündemi meşgul eden yapay zekânın gelecekte hekimlerin yerini alabilme ihtimali üzerinde odaklanıyor.

Sözü uzatmamak açısından, “Yapay zekâ hekimleri işinden edebilir mi?” sorusuna verilebilecek en gerçekçi cevabın yakın, hatta uzak gelecekte “kesinlikle hayır” olacağını rahatlıkla söyleyebilirim.

Yapay zekânın geleceğine ilişkin bir çıkarımda bulunmadan önce gözden kaçırmamamız gereken ilk husus, yapay zekânın da insanlar gibi eğitilerek öğrendiği gerçeğidir. ChatGPT’nin bir anda popüler olup teknoloji devlerini de aynı alanda çalışmaya mecbur bırakmasının ardında yatan en önemli sebep, şirket tarafından uygulamanın yoğun bir şekilde eğitim sürecinden geçirilmiş olmasıydı.

Ancak, sistem toplu kullanıma açıldıktan sonra eğitim süreci yavaşladı. ChatCPT’nin ücretli son sürümünden önceki versiyonu 2021’den sonrasında bazı güncellemeler dışında ciddi bir eğitimden geçirilmedi. Hatta, bazı uzmanların belirttiğine göre sistem sadece kullanıcılarla yaşadığı etkileşimden beslenmeye devam etti. Diğer bir ifade ile, önyargı, hatalı bilgi, kullanıcı algı ve beklentilerine göre verdiği cevaplar da şekillenmeye devam ediyor.

Bunun sonucunda da, son zamanlarda kullanıcılardan çok sayıda olumsuz değerlendirme alıyor. Daha önce bazı yazılarımda verdiğim örneklerde de ifade etmeye çalıştığım üzere, uygulama yanlış cevaplar verebildiği gibi bu cevapların doğru olduğunu da iddia edecek kadar cüretkâr davranabiliyor!

Bu sorunu yaşayan sadece ChatGPT değil. Örneğin, Google Bard geçtiğimiz günlerde sorduğum bir akademik soruya gerçekte var olmayan bazı yayın isimleri önererek cevap vermişti. Bahsettiği akademik dergilerde bu makalelere ulaşamadığım gibi, Google’ın kendi arama motorunda dahi bahsi geçen çalışmalara rastlayamadım. O yüzden de, yapay zekânın gerekli durumlarda dezenformasyona dahi başvurabildiğine de şahitlik etmiş oldum!

Uzmanlar, bu sıkıntının sebebini açıklarken yapay zekânın eğitim maliyeti ve eğitimde kullanılacak gerçek veri erişiminde yaşanan sıkıntılar sonucu ortaya çıktığını, gerçek hayatta kullanıcıların verileri ile eğitimin yapay zekânın gelişim sürecini olumsuz etkilediğini vurguluyor. O yüzden de geleceğe yönelik endişeler açısından sorumluluğu tek yönlü olarak bilişim sektörüne yüklemek yerine kullanıcıların da dikkatli olmaları gerektiği ifade ediliyor.